L’armée israélienne a désigné des dizaines de milliers d’habitants de Gaza comme cibles à assassiner, en utilisant un système de ciblage par IA avec peu de contrôle humain et en adoptant une approche laxiste en matière de pertes humaines, révèlent +972 et Local Call.

Source : 972 Magazine, Yuval Abraham

Traduit par les lecteurs du site Les-Crises

En 2021, un livre intitulé « The Human-Machine Team : How to Create Synergy Between Human and Artificial Intelligence That Will Revolutionize Our World » (L’équipe humain-machine : comment créer une synergie entre l’intelligence humaine et l’intelligence artificielle qui révolutionnera notre monde) a été publié en anglais sous le pseudonyme de « Brigadier General Y.S. » Dans cet ouvrage, l’auteur – un homme dont nous pouvons confirmer qu’il est l’actuel commandant de l’unité d’élite du renseignement israélien 8200 – plaide en faveur de la conception d’une machine spéciale capable de traiter rapidement des quantités massives de données afin de générer des milliers de « cibles » potentielles pour des frappes militaires lorsque la guerre fait rage. Une telle technologie, écrit-il, résoudrait ce qu’il décrit comme un « goulot d’étranglement humain tant pour la localisation de nouvelles cibles que pour la prise de décision pour approuver les cibles ».

Il s’avère qu’une telle machine existe vraiment. Une nouvelle enquête menée par +972 Magazine et Local Call révèle que l’armée israélienne a développé un programme basé sur l’intelligence artificielle, connu sous le nom de « Lavender » (Lavande), dévoilé ici pour la première fois. Selon six officiers de renseignement israéliens, qui ont tous servi dans l’armée pendant la guerre actuelle contre la bande de Gaza et ont été directement impliqués dans l’utilisation de l’IA pour générer des cibles à assassiner, Lavender a joué un rôle clé dans le bombardement sans précédent de Palestiniens, en particulier pendant les premières phases de la guerre. En fait, selon les sources, son influence sur les opérations militaires a été telle que celles-ci traitaient les données fournies par l’IA « comme s’il s’agissait de décisions d’origine humaine ».

Officiellement, le système Lavender est conçu pour marquer comme cibles potentielles à bombarder tous les agents présumés appartenir aux ailes militaires du Hamas et du Jihad islamique palestinien (PIJ), y compris les moins gradés. Les sources ont déclaré à +972 et à Local Call que, pendant les premières semaines de la guerre, l’armée s’est presque entièrement appuyée sur Lavender, qui a pointé jusqu’à 37 000 Palestiniens comme militants présumés – ainsi que leurs maisons – en vue d’éventuelles frappes aériennes.

Au début de la guerre, l’armée a largement autorisé les officiers à adopter les listes d’objectifs de Lavender, sans exiger de vérification approfondie des raisons pour lesquelles la machine avait fait ces choix, ni d’examen des données brutes de renseignement sur lesquelles elles étaient basées. Une source a déclaré que le personnel se contentait bien souvent d’entériner les décisions de la machine, ajoutant que, normalement, seulement « environ 20 secondes » étaient consacrée à chaque cible avant l’autorisation de bombarder – il s’agissait seulement de s’assurer que la cible indiquée par Lavender était bien humaine. Et ceci, tout en reconnaissant que dans environ 10 % des cas le système commet ce que l’on considère comme des « erreurs », et peut occasionnellement pointer des individus qui n’ont qu’un lien ténu avec des groupes militants, voire aucun lien du tout.

En outre, l’armée israélienne a systématiquement attaqué les personnes ciblées alors qu’elles se trouvaient chez elles – généralement la nuit en présence de toute leur famille – plutôt qu’au cours d’une activité militaire. Selon les sources, cela s’explique par le fait que, du point de vue du renseignement, il est plus facile de localiser les individus quand ils se trouvent à leur domicile privé. Par ailleurs, d’autres systèmes informatiques de détection, dont celui appelé « Where’s Daddy ? » (Où est papa ?), dont on révèle ici pour la première fois l’existence ont été utilisés tout spécialement pour localiser les individus ciblés, les suivre et commettre des attentats à la bombe lorsqu’ils étaient entrés dans les résidences familiales.

Des Palestiniens transportent les blessés et tentent d’éteindre un incendie après une frappe aérienne israélienne sur une maison dans le camp de réfugiés de Shaboura dans la ville de Rafah, au sud de la bande de Gaza, le 17 novembre 2023. (Abed Rahim Khatib/Flash90)

Le résultat, comme en témoignent les sources, est que des milliers de Palestiniens – pour la plupart des femmes et des enfants ou des personnes qui n’étaient pas impliquées dans les combats – ont été éliminés par des frappes aériennes israéliennes, en particulier au cours des premières semaines de la guerre, en raison de décisions du programme d’IA.

« Tuer les agents [du Hamas] uniquement lorsqu’ils se trouvaient dans un bâtiment militaire ou qu’ils participaient à une activité militaire ne nous intéressait pas, a déclaré A., un officier de renseignement, à +972 et Local Call. Bien au contraire, Tsahal les a bombardés dans leurs maisons sans aucune hésitation, en première intention. Il est beaucoup plus facile de bombarder une maison d’habitation. Le système est conçu pour les repérer quand ils sont dans cette situation là.»

Le système Lavender complète un autre système d’IA, « Habsora », (Evangile en français) dont le fonctionnement a été révélé lors d’une précédente enquête menée par +972 et Local Call en novembre 2023, et par les publications de l’armée israélienne elle-même. La différence fondamentale entre les deux systèmes réside dans la définition de la cible : alors que Habsora pointe les bâtiments et les structures à partir desquels, selon l’armée, les militants opèrent, Lavender repère les personnes – et les fait figurer sur une liste de personnes à abattre.

De plus, selon les sources, lorsqu’il s’agissait de cibler des militants présumés de second rang, désignés par Lavender, l’armée privilégiait l’utilisation de missiles non guidés, communément appelés bombes « muettes » (par opposition aux bombes de précision « intelligentes »), qui peuvent faire s’écrouler des bâtiments entiers sur leurs occupants et causer de nombreuses pertes humaines. « On n’a pas envie de gaspiller des bombes coûteuses pour des gens qui ne sont pas importants – cela coûte très cher au pays et il y a une pénurie [de ces bombes] », a déclaré C., l’un des officiers de renseignement. Une autre source a déclaré avoir personnellement autorisé le bombardement de « centaines » de domiciles privés appartenant à des agents subalternes présumés indiqués par Lavender, le « dommage collatéral » en a été que nombre de ces attaques ont tué des civils et des familles entières.

Décision sans précédent, selon deux des sources, l’armée a également décidé, au cours des premières semaines de la guerre, que pour chaque agent subalterne du Hamas pointé par Lavender, il était acceptable de tuer jusqu’à 15 ou 20 civils ; par le passé, l’armée n’autorisait aucun « dommage collatéral » lors de l’assassinat de militants de second rang. Les sources ont ajouté que, dans le cas où la cible était un haut responsable du Hamas ayant le rang de commandant de bataillon ou de brigade, l’armée a, à plusieurs reprises, autorisé le meurtre de plus de 100 civils pour l’assassinat d’un seul gradé.

Des Palestiniens attendent pour récupérer les corps de leurs proches qui ont été tués lors d’une frappe aérienne israélienne, à l’hôpital Al-Najjar à Rafah, dans le sud de la bande de Gaza, le 24 octobre 2023. (Abed Rahim Khatib/Flash90)

Dans l’enquête qui suit, nous avons choisi de présenter les six étapes chronologiques du processus hautement automatisée employé par l’armée israélienne pour définir ses cibles au cours des premières semaines de la guerre de Gaza. Tout d’abord, nous décrivons le système Lavender lui-même, celui qui a désigné des dizaines de milliers de Palestiniens à l’aide de l’IA. Ensuite, nous dévoilons le système « Where’s Daddy ? » (Où est papa ?), qui suivait ces cibles et signalait à l’armée qu’elles entraient chez elles. Enfin, nous expliquons comment le choix d’utiliser les bombes « muettes » se faisait afin de frapper ces maisons.

Quatrième point, nous expliquons comment l’armée a assoupli le nombre de civils pouvant être tués lors du bombardement d’une cible. En cinq, nous montrons que les logiciels automatisés calculent de manière inexacte le nombre de non-combattants dans chaque foyer. En six, nous démontrons qu’à plusieurs reprises, lorsqu’une maison a été frappée, généralement la nuit, la cible individuelle n’était parfois même pas là, tout simplement parce que l’information n’avait pas été vérifiée en temps réel par les officiers de Tsahal.

ÉTAPE 1 : DÉFINITION DES CIBLES

‘Une fois le système automatique lancé, le ciblage s’emballe’.

Dans l’armée israélienne, l’expression « cible humaine » désignait autrefois un haut responsable militaire qui, selon les règles du Droit International des armées, pouvait être tué à son domicile privé, même s’il y avait des civils autour de lui. Des sources de renseignement ont déclaré à +972 et à Local Call que lors des précédentes guerres d’Israël, étant donné qu’il s’agissait d’une manière « particulièrement brutale » de tuer quelqu’un – souvent en tuant toute la famille en même temps que la cible – ces cibles humaines étaient déterminées avec le plus grand soin et seuls les commandants militaires de haut rang étaient bombardés chez eux, afin de respecter le principe de proportionnalité en vertu du droit international.

Cependant, après le 7 octobre, lorsque les militants du Hamas ont lancé leur assaut meurtrier contre les communautés du sud d’Israël, tuant environ 1 200 personnes et en enlevant 240, l’armée a adopté une approche radicalement différente, selon les sources. Dans le cadre d’ « opération Iron Swords », l’armée a décidé de considérer tous les agents de la branche militaire du Hamas comme des cibles humaines, quel que soit leur rang ou leur importance militaire. Et cela a tout changé.

Cette nouvelle politique a par ailleurs engendré un problème technique pour les services de renseignement israéliens. Lors des guerres précédentes, pour autoriser l’assassinat d’une seule cible humaine, un officier devait passer par un processus d’« incrimination » long et complexe : vérifier par recoupement des preuves que la personne était bien un membre haut placé de l’aile militaire du Hamas, découvrir où elle vivait, obtenir ses coordonnées et enfin savoir en temps réel quand elle était chez elle. Lorsque la liste des cibles ne comptait que quelques dizaines d’agents de haut rang, les services de renseignement pouvaient s’occuper individuellement du travail d’incrimination et de localisation.

Des Palestiniens tentent de sauver des survivants et de retirer des corps des décombres après que des frappes aériennes israéliennes ont touché des bâtiments près de l’hôpital Al-Aqsa Martyrs à Deir al-Balah, au centre de Gaza, le 22 octobre 2023. (Mohammed Zaanoun/Activestills)

Cependant, une fois que la liste a été élargie pour inclure des dizaines de milliers d’agents de rang inférieur, l’armée israélienne a compris qu’elle devrait s’appuyer sur des logiciels automatisés et sur l’intelligence artificielle. Selon les sources, cela veut dire que le rôle du personnel dans l’incrimination des Palestiniens en tant qu’agents militaires a été mis de côté et que c’est l’intelligence artificielle qui a fait la majeure partie du travail à sa place. Selon quatre des sources qui ont parlé à +972 et à Local Call, Lavender – qui a été développé pour générer des cibles humaines dans la guerre actuelle – a désigné pour être assassinés quelque 37 000 Palestiniens comme étant susceptibles d’être des « militants du Hamas », la plupart d’entre eux de rang inférieur (le porte-parole de Tsahal a nié l’existence d’une telle liste noire lors d’une déclaration faite à +972 et à Local Call).

« Nous ignorions complètement qui étaient ces agents novices dans la mesure où ils n’étaient pas régulièrement suivis par Israël [avant la guerre] », a expliqué l’officier supérieur B. à +972 et à Local Call, justifiant ainsi la raison pour laquelle ce système de ciblage particulier avait été développé pour la guerre en cours. « Il fallait qu’on puisse attaquer automatiquement [les agents subalternes]. C’est le Saint Graal. Une fois automatisée, la définition des cibles s’emballe ».

Les sources ont indiqué que l’autorisation d’adopter automatiquement les listes de personnes à abattre générées par Lavender, qui n’avait auparavant été utilisé que comme outil auxiliaire, a été accordée environ deux semaines après le début de la guerre, après que le personnel des services de renseignement a vérifié « en manuel » le degré d’exactitude d’un échantillon aléatoire de plusieurs centaines de cibles sélectionnées par le système IA. Lorsque ce contrôle a révélé que les résultats de Lavender avaient atteint une précision de 90 % dans l’identification de l’affiliation d’un individu au Hamas, l’armée a autorisé l’utilisation généralisée du système. Selon certaines sources, à partir de ce moment-là, si Lavender décidait qu’un individu était un militant du Hamas, on leur demandait en substance de considérer qu’il s’agissait d’un ordre, sans obligation de vérifier de manière indépendante pourquoi la machine avait fait ce choix ou d’examiner les données brutes de renseignement utilisées à cet effet..

« À 5 heures du matin, [l’armée de l’air] arrivait et bombardait toutes les maisons que nous avions marquées, raconte B.. Nous avons éliminé des milliers de personnes. Nous n’avons pas prcocédé à une vérification individu par individu – nous avons tout mis dans des systèmes automatisés, et dès que l’une [des personnes marquées] était chez elle, elle devenait immédiatement une cible. Nous l’avons bombardé, lui et sa maison.

« Ce qui m’a surpris, c’est qu’on nous demande de bombarder une maison pour tuer un soldat au sol, alors que son importance dans les combats était réellement faible », a déclaré une source au sujet de l’usage de l’IA pour cibler des militants présumés de rang inférieur. J’ai qualifié ces cibles « cibles poubelles ». Néanmoins, je trouvais que ces cibles était plus conformes à l’éthique que celles que nous bombardions uniquement à des fins de « dissuasion »- de hauts immeubles qu’on évacuait et démolissait à la seule fin de provoquer des destructions.»

Les conséquences meurtrières de cet allégement des restrictions au début de la guerre ont été effarantes. Selon les données du ministère palestinien de la santé à Gaza, sur lesquelles l’armée israélienne s’appuie presque exclusivement depuis le début de la guerre, au cours des six premières semaines de la guerre, Israël a tué quelque 15 000 Palestiniens – soit près de la moitié du nombre de morts jusqu’à présent – jusqu’à ce qu’un cessez-le-feu d’une semaine soit conclu le 24 novembre.« Plus il y a d’informations, et plus elles sont diverses et mieux c’est »

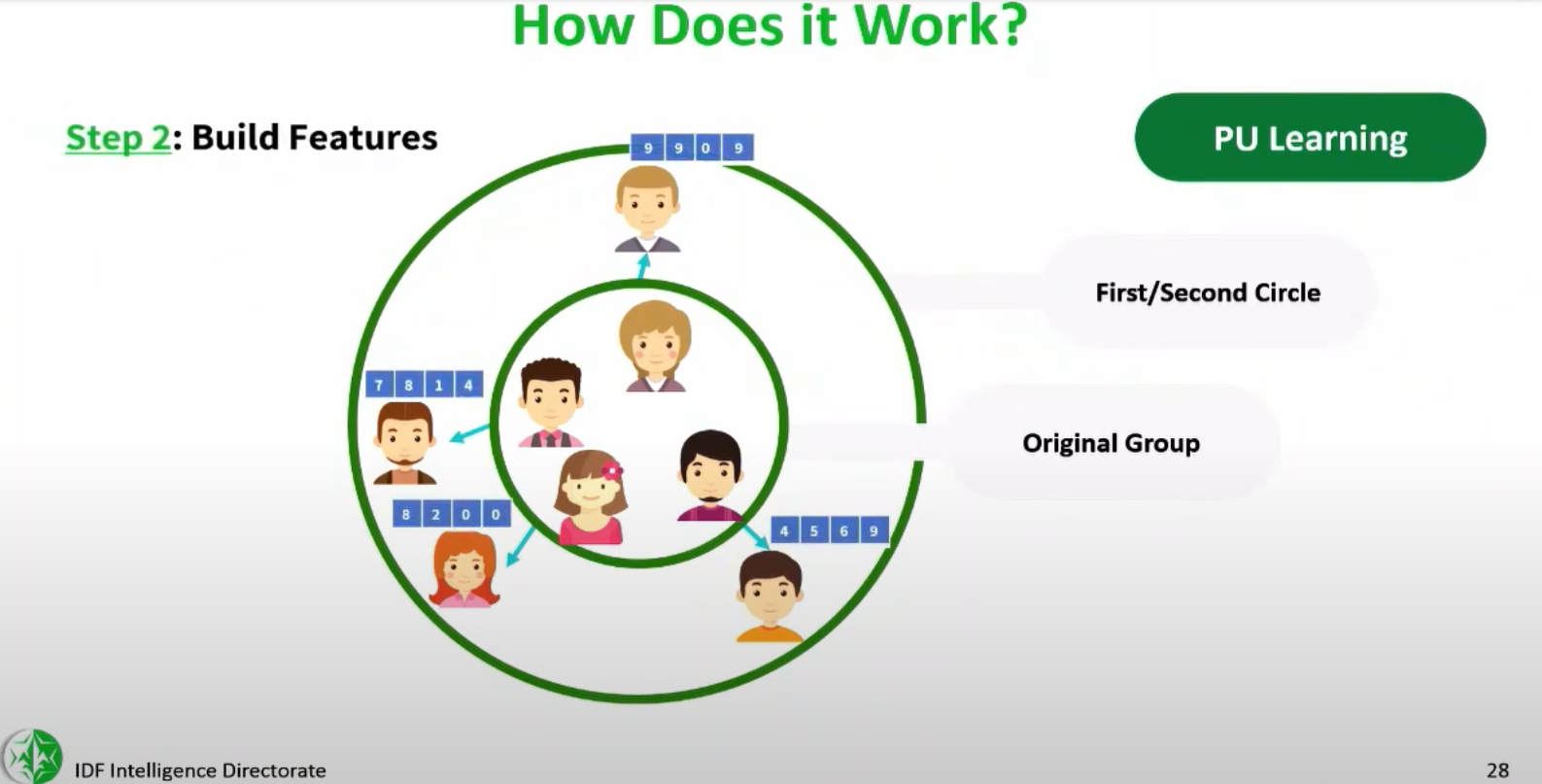

Le logiciel Lavender analyse les informations recueillies concernant la plupart des 2,3 millions d’habitants de la bande de Gaza grâce à un système de surveillance de masse, puis évalue et classe la probabilité que chaque personne soit active dans l’aile militaire du Hamas ou celle du Jihad Islamique Palestinien (JIP). Selon certaines sources, l’IA attribue à la quasi-totalité des habitants de Gaza une note de 1 à 100, traduisant la probabilité qu’il s’agisse d’un combattant.

Lavender apprend à reconnaître les caractéristiques des agents connus du Hamas et du JIP, données qui ont été transmises au système en tant que données du programme, et ensuite à repérer ces mêmes caractéristiques – également appelées « particularités » – au sein de la population générale, ont expliqué les sources. Une personne présentant plusieurs particularités suspectes différentes atteindra un niveau élevé et deviendra ainsi automatiquement une cible potentielle à assassiner.

Dans « The Human-Machine Team », le livre cité au début de cet article, le commandant actuel de l’unité 8200 plaide en faveur d’un tel système sans citer le nom de Lavender. (Le nom du commandant lui-même n’est pas cité non plus, mais cinq sources au sein de l’unité 8200 ont confirmé qu’il en est l’auteur, comme l’a également rapporté Haaretz). Décrivant le personnel comme un « goulot » qui restreint la capacité de l’armée au cours d’une opération militaire, le commandant déplore : « Nous [ humains] sommes incapables de traiter autant d’informations. Peu importe le nombre de personnes chargées de produire des objectifs pendant la guerre, on reste incapable de produire suffisamment d’objectifs chaque jour ».

Selon lui, la solution à ce problème passe par l’intelligence artificielle. Le livre propose un petit guide pour construire une « machine à cibler », dont la description est tout à fait similaire à celle de Lavender, et qui repose sur des algorithmes d’IA et d’apprentissage automatique. On trouve aussi dans ce guide plusieurs exemples de « centaines et de milliers » de particularités susceptibles d’augmenter la cote d’un individu, comme le fait de faire partie d’un groupe Whatsapp avec un militant connu, de remplacer son téléphone portable à intervalles réguliers et de changer fréquemment d’adresse.

« Plus il y a d’informations, et plus elles sont diverses, et mieux c’est, écrit le commandant. Informations visuelles, informations cellulaires, connexions aux médias sociaux, informations sur le champ de bataille, contacts téléphoniques, photos. Alors que dans un premier temps, ce sont les humains qui sélectionnent ces caractéristiques, poursuit le commandant, au fil du temps, la machine en viendra à les identifier d’elle-même. Selon lui, cela peut permettre aux armées de définir « des dizaines de milliers de cibles », la décision de les attaquer ou non restant du ressort de l’homme.

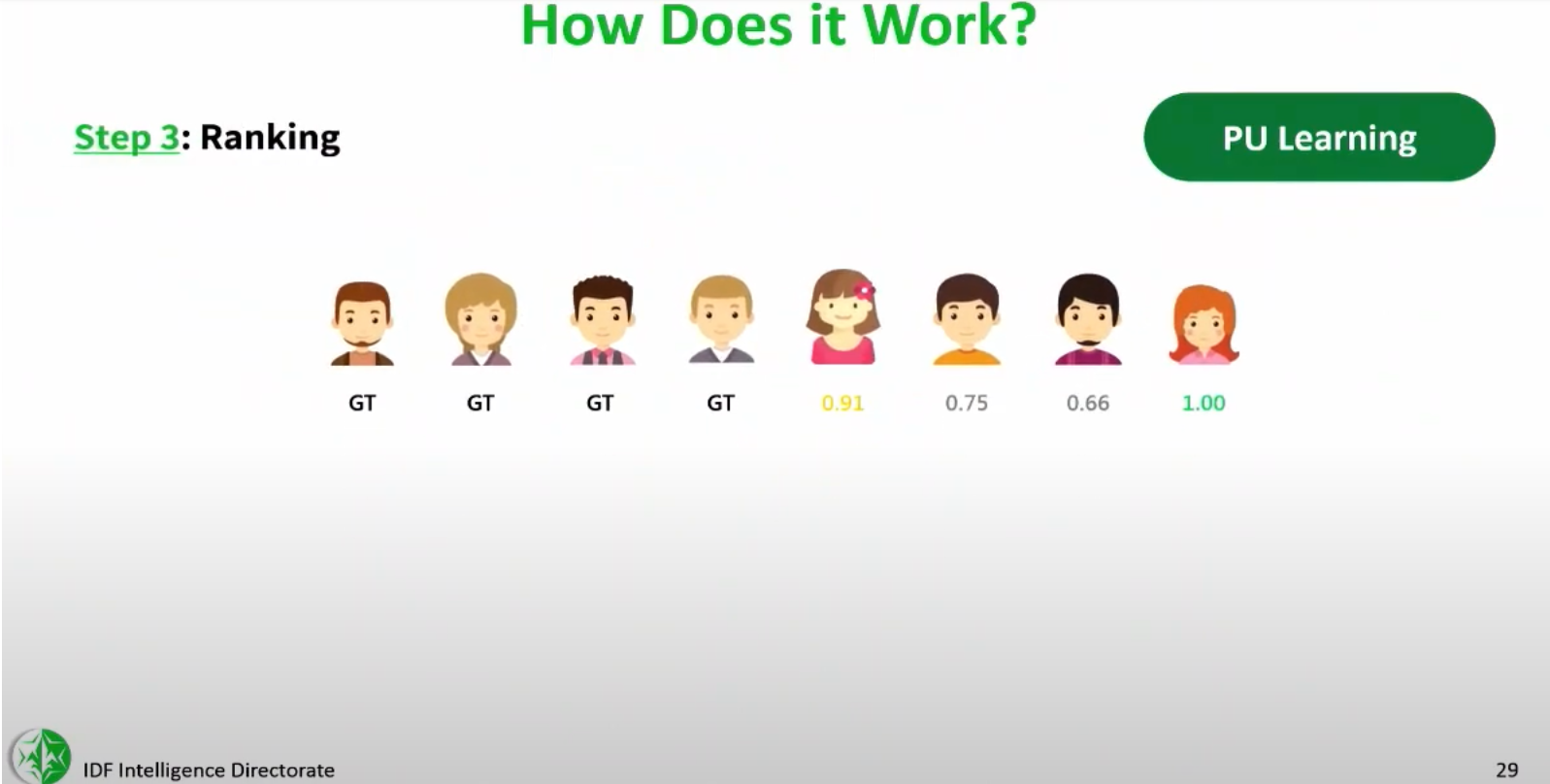

Avec ce livre, ce n’est pas la première fois qu’un haut commandant israélien a fait allusion à l’existence de machines à cibler les humains comme Lavender. +972 et Local Call se sont procuré des images d’une conférence privée donnée par le commandant du centre secret de science des données et d’IA de l’unité 8200, le « colonel Yoav », lors de la semaine de l’IA de l’université de Tel-Aviv en 2023, qui à l’époque a fait l’objet d’un article dans les médias israéliens.

Lors de cette conférence, le commandant parle d’une nouvelle machine à cibler sophistiquée qui est utilisée par l’armée israélienne et qui détecte les « personnes dangereuses » à partir de leur ressemblance avec des militants connus figurant sur des listes existantes à partir desquelles elle a été développée. « Grâce à ce système, nous avons réussi à identifier les commandants des unités de missiles du Hamas », a déclaré le colonel Yoav lors de la conférence, faisant allusion à l’opération militaire israélienne de mai 2021 à Gaza, au cours de laquelle la machine a été utilisée pour la première fois.

Diapositives d’une conférence donnée par le commandant du centre de science des données et d’intelligence artificielle de l’unité 8200 de Tsahal à l’université de Tel-Aviv en 2023, obtenues par +972 et Local Call.

Sur les diapositives de la présentation, également obtenues par +972 et Local Call, figurent des illustrations du fonctionnement de la machine : elle est alimentée grâce aux données concernant les agents du Hamas existants, elle apprend à reconnaître leurs particularités, puis elle évalue d’autres Palestiniens en fonction de leur degré de ressemblance avec ces militants.

« Nous classons les résultats et déterminons le seuil [à partir duquel il convient d’attaquer une cible], a déclaré le colonel Yoav lors de la conférence, soulignant qu’en fin de compte, ce sont des personnes en chair et en os qui prennent les décisions. Dans le domaine de la défense, d’un point de vue éthique, nous insistons beaucoup sur ce point. Ces outils sont destinés à aider [les officiers de renseignement] à faire tomber leurs barrières ».

Dans la pratique, cependant, les sources qui ont utilisé Lavender au cours des derniers mois affirment que l’action humaine et la précision ont été remplacées par la création de cibles de masse et la létalité.

« La politique ‘zéro erreur’ n’existait pas »

B., un officier supérieur qui a utilisé Lavender, expliquait à +972 et à Local Call que, dans le cadre de la guerre actuelle, les officiers n’étaient pas tenus de vérifier de manière indépendante les évaluations du système d’IA, afin de gagner du temps et de permettre la production en masse et sans entraves de cibles humaines.

« Tout était affaire de statistique, tout était propre – c’était très froid », a déclaré B.. Il a expliqué que ce déficit de supervision était autorisé, et ce, en dépit de contrôles internes montrant que les calculs de Lavender n’étaient considérés comme exacts que dans 90 % des cas ; en d’autres termes, on savait à l’avance que 10 % des cibles humaines destinées à être assassinées n’étaient pas du tout des membres de l’aile militaire du Hamas.

Par exemple, des sources ont expliqué que Lavender signalait parfois par erreur des personnes dont les habitudes de communication étaient similaires à celles d’agents connus du Hamas ou du Jihad Islamique, notamment des policiers et des membres de la défense civile, des parents de militants, des habitants dont le nom et le surnom étaient identiques à ceux d’un agent, et des habitants de Gaza qui utilisaient un appareil ayant appartenu à un agent du Hamas.

« Jusqu’à quel point doit-on être proche du Hamas pour être [considéré par une machine d’intelligence artificielle comme] affilié à l’organisation ? a déclaré une source critiquant l’inexactitude de Lavender. La limite est vague. Une personne qui ne reçoit pas de salaire du Hamas, mais qui l’aide pour toutes sortes de choses, est-elle un agent du Hamas ? Une personne qui a fait partie du Hamas dans le passé, mais qui n’en fait plus partie aujourd’hui, est-elle un agent du Hamas ? Chacune de ces caractéristiques – des caractéristiques qu’une machine signalerait comme suspectes – est inexacte.»

Des Palestiniens sur le site d’une frappe aérienne israélienne à Rafah, dans le sud de la bande de Gaza, le 24 février 2024. (Abed Rahim Khatib/Flash90)

Des problèmes similaires se posent en ce qui concerne la capacité des machines à cibler quand il s’agit d’évaluer le téléphone utilisé par une personne désignée pour être assassinée. « En temps de guerre, les Palestiniens changent de téléphone en permanence, explique la source. Les gens perdent le contact avec leur famille, donnent leur téléphone à un ami ou à une épouse, ou le perdent. Il est impossible de se fier à 100 % au mécanisme automatique qui détermine quel numéro de téléphone appartient à qui.»

Selon les sources, l’armée savait très bien que la supervision humaine minimale en vigueur ne permettrait pas de découvrir ces erreurs. Il n’y avait pas de politique « zéro erreur ». Les erreurs étaient traitées de façon statistique, a déclaré une source qui a utilisé Lavender. En raison de la portée et de l’ampleur du projet, le protocole était le suivant : même si l’on n’est pas sûr que la machine a raison, on sait que statistiquement, elle est exacte. Alors, on fonce.»

« Elle a fait ses preuves », a déclaré B., la source principale. Il y a quelque chose dans l’approche statistique qui vous impose une certaine norme et des critères. Lors de cette opération, le nombre d’attentats à la bombe dépasse l’entendement. De mémoire, c’est sans précédent. Et je fais bien plus confiance à un mécanisme statistique qu’à un soldat qui a perdu un ami deux jours plus tôt. Tout le monde, y compris moi, a perdu des gens le 7 octobre. La machine elle, a agi avec sang froid. Et c’est ce qui a rendu les choses plus faciles.»

Une autre source de renseignements, qui a soutenu la fiabilité des listes de suspects palestiniens établies par Lavender, a fait valoir que le temps d’un officier de renseignement ne valait la peine d’être investi que s’il s’agissait de vérifier l’information dans le cas où la cible était un commandant de haut rang au sein du Hamas. « Mais s’il s’agit d’un militant subalterne, il est inutile des gaspiller temps et main-d’œuvre pour ça, a-t-il déclaré. En temps de guerre, on n’a pas le temps de vérifier chaque cible. On est donc prêt à assumer la marge d’erreur liée à l’utilisation de l’intelligence artificielle, à courir le risque de dommages collatéraux et la mort de civils, à envisager une attaque par erreur, et à s’en accommoder.»

- a expliqué ce choix d’automatisation par le souci constant d’augmenter le nombre de cibles à assassiner. « Le jour où il n’y avait pas de cibles [dont l’évaluation des caractéristiques était suffisante pour autoriser une frappe], nous attaquions à un seuil plus bas. On nous mettait constamment la pression : « Apportez-nous plus de cibles ». On nous criait littéralement dessus. Nous avons fini [par tuer] nos cibles très rapidement ».

Des Palestiniens sur le site d’un bâtiment détruit par une frappe aérienne israélienne à Rafah, dans le sud de la bande de Gaza, le 18 mars 2024. (Abed Rahim Khatib/Flash90)

Une source qui a travaillé avec l’équipe militaire de science des données qui a entraîné Lavender a déclaré que les données collectées et concernant des employés du ministère de la sécurité intérieure dirigé par le Hamas, qui ne sont pas considérés comme des militants, ont également été introduites dans la machine. Le fait que lors de l’entraînement de Lavender, le terme « agent du Hamas » ait été utilisé de manière vague et que des personnes travaillant pour la défense civile aient été incluses dans l’ensemble de données d’entraînement du système m’a réellement contrarié », a-t-il déclaré.

La source a ajouté que même si l’on pense que ces personnes méritent d’être tuées, le fait d’entraîner le système en fonction de leurs habitudes de communication rend Lavender plus susceptible de sélectionner des civils par erreur lorsque ses algorithmes sont appliqués à l’ensemble de la population. « Comme il s’agit d’un système automatique qui n’est pas géré manuellement par des humains, les conséquences de cette décision sont dramatiques : cela signifie que de nombreuses personnes présentant des habitudes de communication civiles sont incluses comme cibles potentielles.

« Nous nous sommes contentés de vérifier que la cible était un homme »

L’armée israélienne rejette catégoriquement ces affirmations. Dans une déclaration à +972 et à Local Call, le porte-parole de Tsahal a nié utiliser l’intelligence artificielle pour incriminer des cibles, affirmant qu’il s’agit simplement de «dispositifs auxiliaires qui aident les officiers dans le processus d’incrimination ». Le communiqué poursuit : « En tout état de cause, il est nécessaire de procéder à une vérification en toute indépendance réalisée par un analyste [du renseignement], qui s’assure que les cibles identifiées sont des cibles pouvant légitimement être attaquées, conformément aux dispositions prévues par les directives de Tsahal et par le droit international. »

Toutefois, des sources ont indiqué que le seul protocole de supervision humaine mis en place avant le bombardement de maisons de militants « de second rang » présumés pointés par Lavender consistait à effectuer une seule vérification : s’assurer que la cible sélectionnée par l’IA était bien un homme et non une femme. L’armée partait du principe que si la cible était une femme, la machine s’était probablement trompée, car il n’y a pas de femmes dans les rangs des ailes militaires du Hamas et du JIP.

« Un être humain n’avait que quelques secondes pour vérifier la cible », a déclaré B., expliquant que ce protocole avait été adopté après qu’il ait été observé que le système Lavender « faisait bien les choses » la plupart du temps. « Au début, nous faisions des vérifications pour nous assurer que la machine ne se trompait pas. Mais à un moment donné, nous nous sommes fiés au système automatique et nous nous sommes contentés de vérifier que [la cible] était un homme – c’était suffisant. Il ne faut pas beaucoup de temps pour savoir si quelqu’un a une voix d’homme ou de femme.»

Pour effectuer cette vérification homme/femme, B. affirme que dans la guerre actuelle, « à cette étape, j’avais l’habitude de consacrer 20 secondes à chaque cible, et j’en faisais des dizaines chaque jour. En tant qu’être humain, ma valeur ajoutée était nulle, hormis le fait d’être un sceau d’approbation. Cela a permis de gagner beaucoup de temps. Si [la cible]était identifiée par le système robotisé et après vérification qu’il s’agissait bien d’un homme, la permission de bombarder était accordée, sous réserve toutefois de l’évaluation des dommages collatéraux.»

Des Palestiniens émergent des décombres de maisons détruites par des frappes aériennes israéliennes dans la ville de Rafah, au sud de la bande de Gaza, le 20 novembre 2023. (Abed Rahim Khatib/Flash90)

Dans la pratique, les sources ont déclaré que pour les civils pointés par erreur par Lavender, cela voulait dire qu’il n’y avait aucun mécanisme de supervision permettant de détecter l’erreur. Selon B., il y a une erreur qui a été fréquente « si la cible [du Hamas] donne [son téléphone] à son fils, à son frère aîné ou à un homme au hasard. Cette personne sera bombardée dans sa maison avec sa famille. Cela s’est souvent produit. Voilà les principales erreurs dues à Lavender », a déclaré B.

ÉTAPE 2 : RELIER CIBLES ET DOMICILES FAMILIAUX

La plupart des gens qu’on a tués étaient des femmes et des enfants

Dans la procédure d’assassinat de l’armée israélienne, l’étape suivante consiste à repérer le lieu où attaquer les cibles générées par Lavender.

Dans une déclaration à +972 et à Local Call, en réponse à cet article, le porte-parole de Tsahal a affirmé que « le Hamas place ses agents et ses moyens militaires au cœur de la population civile, utilise systématiquement la population civile comme bouclier humain et mène ses combats depuis l’intérieur de structures civiles, y compris depuis des sites sensibles tels que les hôpitaux, les mosquées, les écoles et les installations de l’ONU. L’armée israélienne est tenue de respecter le droit international et d’agir conformément à celui-ci, en dirigeant ses attaques uniquement contre des cibleset des agents militaires.

Les six sources auxquelles nous avons parlé ont plus ou moins abondé dans le même sens, affirmant que le vaste réseau de tunnels du Hamas passe délibérément sous les hôpitaux et les écoles, que les militants du Hamas utilisent des ambulances pour se déplacer et que d’innombrables équipements militaires ont été placés à proximité de bâtiments civils. Ces sources soutiennent que ce sont ces tactiques du Hamas qui font que de nombreuses frappes israéliennes tuent des civils – une interprétation qui, selon les groupes de défense des droits humains, élude la responsabilité d’Israël en ce qui concerne le nombre de victimes.

Toutefois, et s’opposant en cela aux déclarations officielles de l’armée israélienne, les sources ont expliqué que le nombre sans précédent de victimes des bombardements israéliens actuels s’explique en grande partie par le fait que l’armée a systématiquement attaqué les cibles à leurs domiciles privés, alors qu’elles étaient aux côtés de leurs familles – en partie parce qu’il était plus facile, du point de vue du renseignement, de pointer les maisons familiales à l’aide de systèmes automatisés.

En effet, plusieurs sources ont souligné que, alors que dans de nombreux cas, les agents du Hamas se livraient à des activités militaires à partir de zones civiles, l’armée a délibérément choisi de bombarder des militants présumés lorsqu’ils se trouvaient à l’intérieur de domiciles privés d’où ne partait aucune activité militaire. Ce choix, ont-ils déclaré, reflète la manière dont le système israélien de surveillance de masse à Gaza est conçu.

Des Palestiniens se précipitent pour amener les blessés, dont de nombreux enfants, à l’hôpital Al-Shifa dans la ville de Gaza, alors que les forces israéliennes continuent de pilonner la bande de Gaza, le 11 octobre 2023. (Mohammed Zaanoun/Activestills)

Les sources ont déclaré à +972 et à Local Call que, puisque chaque habitant de Gaza avait un domicile auquel il pouvait être associé, les systèmes de surveillance de l’armée pouvaient facilement et automatiquement « relier » les individus aux maisons familiales. Afin d’identifier en temps réel le moment où les agents entrent dans leurs maisons, divers logiciels automatiques supplémentaires ont été développés. Ces programmes suivent des milliers d’individus simultanément, identifient le moment où ils sont chez eux et envoient une alerte automatique à l’officier chargé du ciblage, celui-ci signale alors la maison à bombarder. L’un de ces logiciels de pistage, révélé ici pour la première fois, s’appelle « Where’s Daddy ? » (Où est papa ?).

«Vous entrez des centaines [de cibles] dans le système et vous attendez de voir qui vous pouvez tuer, a déclaré une source connaissant le système. C’est ce qu’on appelle la chasse à grande échelle : vous faites des copié/collé à partir des listes produites par le système de ciblage ».

La preuve de cette politique est clairement apportée par les données : au cours du premier mois de la guerre, plus de la moitié des victimes – 6 120 personnes – appartenaient à 1 340 familles, dont beaucoup ont été complètement anéanties alors qu’elles étaient au sein de leurs domiciles, selon les chiffres de l’ONU. Le pourcentage de familles entières bombardées dans leurs maisons au cours de la guerre actuelle est beaucoup plus élevé que lors de l’opération israélienne de 2014 à Gaza (qui était jusque-là la guerre la plus meurtrière menée par Israël dans la bande de Gaza), ce qui confirme la prédominance de cette politique..

Une autre source a déclaré que chaque fois que le rythme des assassinats diminuait, de nouvelles cibles étaient ajoutées à des systèmes tels que Where’s Daddy ? pour localiser les individus qui rentraient chez eux et pouvaient donc être bombardés. Selon cette source, c’était parfois des officiers de rang relativement bas dans la hiérarchie militaire qui décidaient des personnes à inclure dans les systèmes de traçage.

« Un jour, de mon propre chef, j’ai ajouté quelque 1 200 nouvelles cibles au système [de suivi], parce que le nombre d’attaques [que nous menions] diminuait, a déclaré la source. Cela me paraissait logique. Rétrospectivement, je pense que cette décision a été prise avec sérieux. Et de telles décisions n’ont pas été prises à des niveaux élevés ».

Les sources ont déclaré qu’au cours des deux premières semaines de la guerre, « plusieurs milliers » de cibles ont été enregistrées dans des programmes de localisation tels que « Où est papa ». Il s’agissait notamment de tous les membres de l’unité d’élite des forces spéciales du Hamas, la Nukhba, de tous les spécialistes antichars du Hamas et de toute personne entrée en Israël le 7 octobre. Mais très vite, la liste des personnes à abattre s’est considérablement allongée.

« En fin de compte, il s’agissait de tout le monde [pointé par Lavender], a expliqué une source. Des dizaines de milliers de gens. Tout cela s’est produit quelques semaines plus tard, lorsque les brigades [israéliennes] sont entrées dans Gaza et qu’il y avait déjà moins de personnes non impliquées [c’est-à-dire de civils] dans les zones du nord ». Selon cette source, Lavender a même désigné des mineurs comme cibles à bombarder. « Normalement, les agents ont plus de 17 ans, mais ce n’était pas une exigence ».

Des blessés palestiniens sont soignés à même le sol en raison de la surpopulation de l’hôpital Al-Shifa, dans la ville de Gaza, au centre de la bande de Gaza, le 18 octobre 2023. (Mohammed Zaanoun/Activestills)

Lavender et des systèmes comme Where’s Daddy ? ont donc été utilisés simultanément avec un effet meurtrier, tuant des familles entières, d’après certaines sources. En ajoutant un nom figurant sur les listes générées par Lavender au système Where’s Daddy de localisation des domiciles, a expliqué A., la personne ciblée était placée sous surveillance permanente et pouvait être attaquée dès qu’elle mettait le pied chez elle, ce qui faisait s’effondrer la maison sur tous ceux qui s’y trouvaient.

« Admettons que selon vos calculs il y a un] [agent] du Hamas et 10 [civils dans la maison], explique A.. De façon générale, ces dix personnes sont des femmes et des enfants. Par conséquent, et c’est absurde, il s’avère que la plupart des personnes que vous avez tuées étaient des femmes et des enfants.

ÉTAPE 3 : CHOIX DE L’ ARME

« Les attaques étaient généralement menées au moyen de « bombes muettes ». »

Une fois que Lavender a désigné une cible à assassiner, que le personnel de l’armée a vérifié qu’il s’agissait bien d’un homme et que le logiciel de suivi a localisé la cible à son domicile, l’étape suivante consiste à choisir la munition avec laquelle on va la bombarder.

En décembre 2023, CNN a rapporté que, selon les estimations des services de renseignement américains, environ 45 % des munitions utilisées par l’armée de l’air israélienne à Gaza étaient des bombes « muettes », dont on sait qu’elles causent plus de dommages collatéraux que les bombes guidées. En réponse à l’article de CNN, un porte-parole de l’armée cité dans l’article a déclaré : « En tant qu’armée soucieuse du respect du droit international et d’un code de conduite moral, nous consacrons d’importantes ressources pour limiter au maximum les dommages causés aux civils que le Hamas a contraints à jouer le rôle de boucliers humains. Notre guerre est contre le Hamas, pas contre la population de Gaza ».

Trois sources de renseignements ont cependant déclaré à +972 et à Local Call que pour assassiner les agents subalternes indiqués par Lavender, seules les bombes muettes étaient utilisées, afin d’économiser les armements plus coûteux. L’une des sources a expliqué que cela voulait dire qu’une cible de second rang n’était pas frappée si elle vivait dans un immeuble de grande hauteur, parce que l’armée ne voulait pas gaspiller une bombe précise mais plus coûteuse, aux effets collatéraux plus limités. En revanche, si une cible de rang inférieur vivait dans un immeuble de quelques étages seulement, l’armée était autorisée à la tuer, ainsi que tous les habitants de l’immeuble, en utilisant une bombe muette.

Des Palestiniens sur le site d’un bâtiment détruit par une frappe aérienne israélienne à Rafah, dans le sud de la bande de Gaza, le 18 mars 2024. (Abed Rahim Khatib/Flash90)

« Il en était ainsi pour toutes les cibles de second rang, témoigne C., qui a utilisé divers programmes automatisés dans la guerre actuelle. La seule question était de savoir s’il était possible d’attaquer le bâtiment en limitant les dommages collatéraux. En effet, nous menions généralement les attaques avec des bombes muettes, ce qui voulait dire détruire littéralement la maison entière en la faisant s’écrouler sur ses occupants. Et même si une attaque est empêchée, on s’en fiche, on passe immédiatement à la cible suivante. Grâce au système, la liste des cibles n’est jamais épuisée. Il y en a encore 36 000 qui attendent.

ÉTAPE 4 : AUTORISER LES PERTES CIVILES

« Nous avons attaqué en ne nous souciant pratiquement pas des dommages collatéraux »

Une source a déclaré que lors de l’attaque d’agents subalternes, y compris ceux pointés par des systèmes d’IA comme Lavender, le nombre de civils qu’ils étaient autorisés à tuer en même temps que chaque cible était, au cours des premières semaines de la guerre, fixé à 20 au maximum. Selon une autre source, ce nombre aurait été fixé à 15. Ces « degrés de dommages collatéraux », comme les militaires les appellent, ont été globalement adoptés envers tous les militants de moindre importance, ont indiqué les sources, indépendamment de leur rang, de leur intérêt militaire et de leur âge, et sans examen spécifique au cas par cas pour évaluer les avantages militaires de leur assassinat au regard des dommages escomptés pour les civils.

Selon A., ancien officier d’une salle d’opérations de ciblage dans la guerre actuelle, jamais auparavant, le département du droit international de l’armée n’avait donné une approbation aussi radicale pour un niveau de dommages collatéraux aussi élevé. « Ce n’est pas seulement que vous pouvez tuer toute personne qui est un soldat du Hamas, ce qui est clairement autorisé et légitime en termes de droit international, a déclaré A.. Mais on vous dit carrément : Vous avez le droit de les tuer avec un grand nombre de civils.

« Tout individu ayant porté un uniforme du Hamas au cours de l’année ou des deux années précédentes pouvait être bombardé ainsi que 20 [civils tués] considérés comme des dommages collatéraux, même sans autorisation spéciale, a poursuivi M. A.. Dans la pratique, le principe de proportionnalité n’existait pas ».

Selon A., voilà la politique qui a été appliquée pendant la majeure partie de la période où il a servi. Ce n’est que plus tard que l’armée a abaissé le niveau des dommages collatéraux. « Dans ce calcul, cela pouvait aussi pouvoir dire 20 enfants pour un agent subalterne… Ce n’était pas vraiment le cas dans le passé », a expliqué A.. Interrogé sur la logique sécuritaire qui sous-tend cette politique, A. a répondu : « La létalité ».

Des Palestiniens attendent de récupérer les corps de leurs proches qui ont été tués dans des frappes aériennes israéliennes, à l’hôpital Al-Najjar à Rafah, dans le sud de la bande de Gaza, le 7 novembre 2023. (Abed Rahim Khatib/Flash90)

Selon certaines sources, le degré prédéfini et imposé de dommages collatéraux a contribué à accélérer la création massive de cibles grâce la machine Lavender, expliquent les sources, car cela permettait de gagner du temps. B. a affirmé que le nombre de civils qu’ils étaient autorisés à tuer au cours de la première semaine de la guerre pour chaque militant de second rang présumé pointé par l’IA était de quinze, mais que ce nombre n’arrêtait pas d’augmenter et diminuer » au fil du temps.

« Au début, nous attaquions pratiquement sans tenir compte des dommages collatéraux, a déclaré B. à propos de la première semaine qui a suivi le 7 octobre. En pratique, on ne comptait pas vraiment les personnes [dans chaque maison bombardée], parce qu’on ne pouvait pas vraiment savoir si elles étaient à la maison ou non. Au bout d’une semaine, les restrictions sur les dommages collatéraux ont commencé. Le nombre est passé [de 15] à cinq, ce qui a rendu nos attaques très difficiles, car si toute la famille était à la maison, nous ne pouvions pas la bombarder. Puis ils ont à nouveau augmenté ce nombre.

« Nous savions que nous allions tuer plus de 100 civils »

Des sources ont déclaré à +972 et à Local Call qu’aujourd’hui, en partie à cause de la pression américaine, l’armée israélienne ne génère plus en masse des cibles humaines de rang inférieur à bombarder dans les maisons des civils. Le fait que la plupart des maisons de la bande de Gaza aient déjà été détruites ou endommagées, et que la quasi-totalité de la population ait été déplacée, a également empêché l’armée de s’appuyer sur des bases de données de renseignements et des programmes automatisés de localisation des maisons.

- a affirmé que les bombardements massifs des militants de second rang ne se sont produits que durant la première ou les deux premières semaines de la guerre, et que tout ça s’est arrêté, principalement pour ne pas gaspiller les bombes. « Il existe une économie des munitions, a déclaré E. Ils avaient toujours peur qu’il y ait [une guerre] dans la zone nord [avec le Hezbollah au Liban]. Ils n’attaquent plus du tout ce style de gens [de rang inférieur].»

Toutefois, les frappes aériennes contre les hauts responsables du Hamas se poursuivent, et des sources ont indiqué que pour ces attaques, l’armée autorise le meurtre de « centaines » de civils pour chaque« cible – une politique officielle pour laquelle il n’existe aucun précédent historique en Israël, ni même dans les récentes opérations militaires des États-Unis.

« Lors de l’attaque par bombe contre le commandant du bataillon Shuja’iya, nous savions que nous allions tuer plus de 100 civils », se souvient B. parlant du bombardement du 2 décembre qui, selon le porte-parole de Tsahal, visait à assassiner Wisam Farhat. « Pour moi, psychologiquement, c’était inhabituel. Plus de 100 civils – on franchit une ligne rouge ».

Une boule de feu et de fumée s’élève lors de frappes aériennes israéliennes dans la bande de Gaza, le 9 octobre 2023. (Atia Mohammed/Flash90)

Amjad Al-Sheikh, un jeune Palestinien de Gaza, a déclaré que de nombreux membres de sa famille avaient été tués lors de ce bombardement. Résident de Shuja’iya, à l’est de la ville de Gaza, il se trouvait ce jour-là au supermarché local lorsqu’il a entendu cinq explosions qui ont brisé les vitres.

« J’ai couru jusqu’à la maison de ma famille, mais il n’y avait plus d’immeuble, a déclaré Al-Sheikh à +972 et Local Call. La rue était pleine de cris et de fumée. Des pâtés de maisons entiers étaient devenus des montagnes de décombres et des fosses profondes. Les gens ont commencé à fouiller à mains nues dans le béton, et j’ai fait la même chose, à la recherche de traces de la maison de ma famille ».

La femme et la petite fille d’Al-Sheikh ont survécu – protégées des décombres par une armoire qui était tombée sur elles – mais il a trouvé 11 autres membres de sa famille, dont ses sœurs, ses frères et leurs jeunes enfants, morts sous les décombres. Selon l’organisation de défense des droits humains B’Tselem, les bombardements de ce jour-là ont détruit des dizaines d’immeubles, tué des dizaines de gens et en ont enseveli des centaines sous les ruines de leurs maisons.

« Des familles entières ont été tuées »

Des sources de renseignements ont déclaré à +972 et à Local Call qu’ils ont participé à des frappes encore plus meurtrières. Afin d’assassiner Ayman Nofal, le commandant de la Brigade centrale de Gaza du Hamas, une source a déclaré que l’armée avait autorisé le meurtre d’environ 300 civils, détruisant plusieurs immeubles lors de frappes aériennes sur le camp de réfugiés d’Al-Bureij le 17 octobre, sur la base d’un repérage imprécis de Nofal. Des images satellite et des vidéos de la scène montrent la destruction de plusieurs grands immeubles d’habitation à plusieurs étages.

« Entre 16 et 18 maisons ont été détruites lors de l’attaque, a déclaré Amro Al-Khatib, un résident du camp, à +972 et à Local Call. On ne pouvait plus distinguer les appartements les uns des autres – ils se sont tous mélangés dans les décombres, et nous avons trouvé des parties de corps humains partout.»

Au lendemain de la catastrophe, Al-Khatib se souvient qu’une cinquantaine de cadavres ont été retirés des décombres et qu’environ 200 personnes ont été blessées, dont un grand nombre grièvement. Mais ce n’était là que le premier jour. Les habitants du camp ont, pendant cinq jours, continué de sortir les morts et les blessés, a-t-il déclaré.

Des Palestiniens creusant, mains nues, trouvent un cadavre dans les décombres après une frappe aérienne israélienne qui a tué des dizaines de Palestiniens au milieu du camp de réfugiés d’Al-Maghazi, au centre de la bande de Gaza, le 5 novembre 2023. (Mohammed Zaanoun/Activestills)

Nael Al-Bahisi, ambulancier, a été l’un des premiers à arriver sur les lieux. Il a dénombré entre 50 et 70 victimes ce premier jour. « À un moment donné, nous avons compris que la cible de la frappe était le commandant du Hamas Ayman Nofal, a-t-il déclaré à +972 et à Local Call. Ils l’ont tué, ainsi que de nombreuses personnes qui ne savaient pas qu’il était là. Des familles entières avec des enfants ont été tuées.»

Une autre source de renseignements a déclaré à +972 et à Local Call que l’armée avait détruit une tour d’habitation à Rafah à la mi-décembre, tuant « des dizaines de civils », afin d’essayer de tuer Mohammed Shabaneh, le commandant de la brigade du Hamas à Rafah (on ne sait pas s’il a été tué ou non dans l’attaque). Selon la source, les hauts commandants se cachent souvent dans des tunnels qui passent sous des bâtiments civils, et le choix de les assassiner par une frappe aérienne entraîne donc nécessairement la mort de civils.

« La plupart des blessés étaient des enfants », a déclaré Wael Al-Sir, 55 ans, qui a assisté à la frappe de grande envergure que certains habitants de Gaza considèrent comme une tentative d’assassinat. Il a déclaré à +972 et à Local Call que le bombardement du 20 décembre avait détruit « tout un quartier résidentiel » et tué au moins 10 enfants.

« La politique concernant les victimes des opérations [de bombardement] était totalement permissive – tellement permissive qu’à mon avis, elle avait un caractère de vengeance, affirme D., une source des services de renseignement. L’élément central était l’assassinat de hauts responsables [du Hamas et du PIJ] pour lesquels ils étaient prêts à tuer des centaines de civils. Nous avons fait un calcul : combien pour un commandant de brigade, combien pour un commandant de bataillon, etc.

« Il y avait des règles, mais elles étaient très souples, a déclaré E., une autre source de renseignements. Nous avons tué des gens entraînant ainsi des dommages collatéraux à deux chiffres, voire à trois chiffres. Ce sont des choses qui ne s’étaient jamais produites auparavant ».

Des Palestiniens inspectent leurs maisons et tentent de sauver leurs proches sous les décombres après une frappe aérienne israélienne dans la ville de Rafah, dans le sud de la bande de Gaza, le 22 octobre 2023. (Abed Rahim Khatib/Flash90)

Un taux aussi élevé de « dommages collatéraux » est exceptionnel non seulement si on compare à ce que l’armée israélienne jugeait acceptable auparavant, mais aussi par rapport aux guerres menées par les États-Unis en Irak, en Syrie et en Afghanistan.

Le général Peter Gersten, commandant adjoint des opérations et du renseignement dans le cadre de l’opération de lutte contre l’EI en Irak et en Syrie, a déclaré à un magazine de défense américain en 2021 qu’une attaque qui impliquait des dommages collatéraux à hauteur de 15 civils s’écartait de la procédure ; pour mener à bien une telle opération, il lui fallait obtenir une autorisation spéciale du chef du commandement central américain, le général Lloyd Austin, qui est aujourd’hui Secrétaire à la défense.

« Dans le cas d’Oussama Ben Laden, la NCV (Non-Combatant Casualty Value, Nombre de victimes non combattantes ) était de 30, mais dans le cas d’un commandant de rang inférieur, la NCV était généralement de zéro, a déclaré Gersten. « Nous sommes restés à zéro pendant très longtemps.»

On nous a dit : « Faites tout votre possible, bombardez » »

Toutes les sources interrogées dans le cadre de cette enquête ont déclaré que les massacres perpétrés par le Hamas le 7 octobre et l’enlèvement des otages avaient fortement influencé la politique de l’armée en matière de tirs et de degrés de dommages collatéraux.« Au début, les esprits étaient au chagrin et à la vengeance », a déclaré B., qui a été enrôlé dans l’armée immédiatement après le 7 octobre et a servi dans une salle d’opérations. « Les règles étaient très souples. On a détruit quatre immeubles quand on a appris que la cible se trouvait dans l’un d’entre eux. C’était de la folie ».

« Il y avait une incohérence : d’un côté, les gens ici étaient furieux que nous n’attaquions pas suffisamment, a poursuivi B. De l’autre, à la fin de la journée, on se rendait compte qu’un millier d’habitants de Gaza étaient morts, pour la plupart des civils ».

« Il y avait une réelle hystérie dans les rangs des professionnels, raconte D., qui a lui aussi été recruté immédiatement après le 7 octobre. Ils ne savaient pas du tout comment réagir. Leur seule réaction était de commencer à bombarder comme des forcenés pour essayer de démanteler les capacités du Hamas ».

Le ministre de la Défense Yoav Gallant s’entretient avec des soldats israéliens dans une zone de déploiement non loin de la frontière de Gaza, le 19 octobre 2023. (Chaim Goldberg/Flash90)

D. a souligné qu’on ne leur avait pas expressément indiqué que l’objectif de l’armée était la « vengeance », mais a précisé que « dès que toute cible liée au Hamas devient légitime, et que quasiment tous les dommages collatéraux sont approuvés, on sait parfaitement que des milliers de personnes vont être tuées. Même si officiellement chaque cible est liée au Hamas, lorsque la politique est si permissive, elle perd tout son sens ».

A. a également utilisé le mot « revanche » pour décrire le climat au sein de l’armée après le 7 octobre. « Personne n’a pensé à l’après, une fois la guerre terminée, ou à comment il serait possible de vivre à Gaza et à ce qu’on en ferait, a déclaré A.. On nous a dit : maintenant, il faut foutre en l’air le Hamas, quel qu’en soit le prix. Tout ce qui est possible, vous le bombardez.

B., la principale source de renseignements, a déclaré qu’avec le recul, il pensait que cette politique « disproportionnée » consistant à tuer des Palestiniens à Gaza mettait également en danger les Israéliens, et que c’était l’une des raisons pour lesquelles il avait décidé d’accepter l’interview.

« À court terme, nous sommes plus en sécurité, car nous avons atteint le Hamas. Mais à long terme, je pense que nous sommes moins en sécurité. Je pense que toutes les familles endeuillées de Gaza – c’est-à-dire presque tout le monde – inciteront les gens à rejoindre le Hamas dans dix ans. Et il sera beaucoup plus facile pour le Hamas de les recruter.

Dans une déclaration à +972 et à Local Call, l’armée israélienne a nié une grande partie de ce que les sources nous ont dit, affirmant que « chaque cible est vérifiée individuellement, tandis qu’une évaluation individuelle est faite de l’avantage militaire et des dommages collatéraux attendus de l’attaque … Tsahal ne mène pas d’attaques lorsque les dommages collatéraux attendus de l’attaque sont excessifs par rapport à l’avantage militaire ».

ÉTAPE 5 : CALCUL DES DOMMAGES COLLATÉRAUX

« Le modèle n’ a aucun lien avec la réalité »

Selon les sources de renseignement, pour calculer le nombre de civils susceptibles d’être tués dans chaque maison située à côté d’une cible – une procédure examinée dans une enquête précédente de +972 et Local Call – l’armée israélienne s’est servie d’outils automatiques et imprécis. Lors des guerres précédentes, les services de renseignement passaient beaucoup de temps à vérifier le nombre de personnes présentes dans une maison destinée à être bombardée, le nombre de civils susceptibles d’être tués étant répertorié dans un « fichier de cibles ». Après le 7 octobre, cependant, cette vérification approfondie a été largement abandonnée au profit de l’automatisation.

En octobre, le New York Times a révélé l’existence d’un système exploité à partir d’une base spéciale dans le sud d’Israël, lequel recueille des informations à partir de téléphones portables dans la bande de Gaza et fournit à l’armée une estimation en temps réel du nombre de Palestiniens qui ont fui le nord de la bande de Gaza pour se diriger vers le sud. Le général de brigade Udi Ben Muha a déclaré au Times : « Ce n’est pas un système parfait à 100 %, mais il vous donne les informations dont vous avez besoin pour prendre une décision ». Le système fonctionne par couleurs : le rouge indique les zones où il y a beaucoup de monde, tandis que le vert et le jaune indiquent les zones qui ont été relativement débarrassées de leurs habitants.

Des Palestiniens marchent sur une route principale après avoir fui leurs maisons dans la ville de Gaza, ils se dirigent vers la partie sud de Gaza, le 10 novembre 2023. (Atia Mohammed/Flash90)

Les sources qui ont parlé à +972 et à Local Call ont décrit un système similaire de calcul des dommages collatéraux, utilisé pour décider de bombarder ou non un bâtiment à Gaza. Elles ont indiqué que le logiciel calculait le nombre de civils résidant dans chaque maison avant la guerre – en évaluant la taille du bâtiment et en examinant sa liste de résidents – et réduisait ensuite ces chiffres en fonction de la proportion de résidents censés avoir évacué le quartier.

Par exemple, si l’armée estimait que la moitié des habitants d’un quartier avaient quitté les lieux, le programme comptabilisait une maison comptant habituellement 10 habitants comme une maison habitée par cinq personnes. Pour gagner du temps, l’armée ne surveillait pas les maisons pour vérifier combien de personnes y vivaient réellement, ce qu’elle faisait lors d’opérations précédentes, afin de savoir si l’estimation du programme était effectivement exacte.

« Ce modèle n’avait aucun lien avec la réalité, affirme une source. Il n’y avait rien à voir entre les personnes qui se trouvaient dans la maison aujourd’hui, pendant la guerre, et celles qui avaient été recensées comme vivant là avant la guerre. [Il nous est arrivé de] bombarder une maison sans savoir que plusieurs familles s’y cachaient ensemble.

Selon la source, bien que l’armée ait su que de telles erreurs pouvaient se produire, ce modèle imprécis a tout de même été adopté, car il était plus rapide. Ainsi, selon la source, « le calcul des dommages collatéraux était complètement automatique et statistique », fournissant même des chiffres qui n’étaient pas des nombres entiers.

ÉTAPE 6 : BOMBARDEMENT D’UNE MAISON FAMILIALE

« On a tué toute une famille sans aucune raison »

Les sources qui ont parlé à +972 et à Local Call ont expliqué qu’il y avait parfois un décalage important entre le moment où des systèmes de localisation comme Where’s Daddy ? alertaient un officier qu’une cible était entrée dans sa maison, et le bombardement lui-même – ce qui a conduit au meurtre de familles entières sans même que la cible décidée par l’armée ne soit atteinte. « Il m’est arrivé plusieurs fois d’attaquer une maison, mais la personne n’était même pas chez elle, a déclaré une source. Résultat, on a tué toute une famille sans aucune raison »

Trois sources de renseignements ont déclaré à +972 et à Local Call avoir été témoins d’un incident au cours duquel l’armée israélienne a bombardé le domicile privé d’une famille, et il s’est avéré par la suite que la cible visée par l’assassinat ne se trouvait même pas à l’intérieur de la maison, aucune autre vérification n’ayant été effectuée en temps réel.

Des Palestiniens récupèrent les corps de membres de leur famille qui ont été tués lors de frappes aériennes israéliennes, à l’hôpital Al-Najjar, dans le sud de la bande de Gaza, le 6 novembre 2023. (Abed Rahim Khatib/Flash90)

« Parfois, [la cible] rentrait chez elle plus tôt, puis le soir, allait dormir ailleurs, par exemple dans un souterrain, et ça, on ne le savait pas, a déclaré l’une des sources. Quelques fois on vérifie deux fois l’emplacement, et d’autres fois, on se dit simplement : ‘ OK, il était dans la maison au cours des dernières heures, alors on peut tout simplement bombarder ».

Une autre source a décrit un incident similaire qui l’a affecté et l’a incité à accepter d’être interrogé dans le cadre de cette enquête. « On a compris que la cible était chez elle à 20 heures. Finalement, l’armée de l’air a bombardé la maison à 3 heures du matin. On a découvert ensuite que durant ce laps de temps, il avait réussi à aller dans un autre bâtiment avec sa famille. Il y avait deux autres familles avec des enfants dans le bâtiment que nous avons bombardé ».

Lors des précédentes guerres à Gaza, après l’assassinat de cibles humaines, les services de renseignement israéliens effectuaient des procédures d’évaluation des dommages causés par les bombes (BDA) – une vérification de routine après la frappe pour voir si le commandant en chef avait été tué et combien de civils avaient été tués en même temps que lui. Comme l’a révélé une précédente enquête de +972 et de Local Call, cela nécessitait l’écoute des appels téléphoniques des parents qui avaient perdu leurs proches. Dans la guerre actuelle, cependant, au moins en ce qui concerne les militants subalternes ciblés à l’aide de l’IA, les sources affirment que cette procédure a été supprimée afin de gagner du temps. Les sources ont déclaré qu’elles ne savaient pas combien de civils avaient été effectivement tués dans chaque frappe, et qu’en ce qui concernent les militants présumés de bas rang du Hamas et du PIJ ciblés par l’IA, elles ne savaient même pas si la cible elle-même avait été tuée.

« On ne sait pas exactement combien de gens on a tué et qui sont ces gens », a déclaré une source des services de renseignement à Local Call dans le cadre d’une précédente enquête publiée en janvier. « Ce n’est que dans le cas de hauts responsables du Hamas que la procédure BDA est respectée. Dans les autres cas, on s’en fiche. On reçoit un rapport de l’armée de l’air indiquant si le bâtiment a été détruit, et c’est tout. On n’a absolument aucune idée de l’ampleur des dommages collatéraux ; on passe immédiatement à la cible suivante. L’accent était mis sur la création d’autant de cibles que possible, aussi rapidement que possible ».

Mais alors que l’armée israélienne peut tourner la page après chaque frappe sans s’attarder sur le nombre de victimes, Amjad Al-Sheikh, le résident de Shuja’iya qui a perdu 11 membres de sa famille dans le bombardement du 2 décembre, a déclaré que lui et ses voisins sont toujours à la recherche de cadavres.

« Encore aujourd’hui, il y a des corps sous les décombres, a-t-il déclaré. Quatorze immeubles résidentiels ont été bombardés, leurs habitants étant à l’intérieur. Certains de mes proches et de mes voisins sont toujours enfouis ».

Yuval Abraham

Yuval Abraham est journaliste et cinéaste, il vit à Jérusalem.

Source : 972 Magazine, Yuval Abraham, 03-04-2024

Traduit par les lecteurs du site Les-Crises

Nous vous proposons cet article afin d'élargir votre champ de réflexion. Cela ne signifie pas forcément que nous approuvions la vision développée ici. Dans tous les cas, notre responsabilité s'arrête aux propos que nous reportons ici. [Lire plus]Nous ne sommes nullement engagés par les propos que l'auteur aurait pu tenir par ailleurs - et encore moins par ceux qu'il pourrait tenir dans le futur. Merci cependant de nous signaler par le formulaire de contact toute information concernant l'auteur qui pourrait nuire à sa réputation.

Commentaire recommandé

En un mot INHUMAIN !

La délégation de l’acte de tuer à un système d’information fait perdre tous les repères moraux d’humanité !

– choix des cibles suivant un modèle informatiques avec des critères et des variables même si « Le modèle n’a aucun lien avec la réalité »

– guidage « automatique » jusqu’à la cible choisie sans tenir compte des impacts collatéraux

…

Je me pose la question au niveau d’un tribunal : QUI EST RESPONSABLE ?

10 réactions et commentaires

En un mot INHUMAIN !

La délégation de l’acte de tuer à un système d’information fait perdre tous les repères moraux d’humanité !

– choix des cibles suivant un modèle informatiques avec des critères et des variables même si « Le modèle n’a aucun lien avec la réalité »

– guidage « automatique » jusqu’à la cible choisie sans tenir compte des impacts collatéraux

…

Je me pose la question au niveau d’un tribunal : QUI EST RESPONSABLE ?

+16

AlerterLes gens qui ont écrit le cahier des charges du programme en question sont les résponsables.

J’en avais déjà parlé il y a quelques mois quand on avait découvert l’IA « GOSPEL » utilisée pour les bombardements. On va les découvrir une par une ces IA, il y en a un peu pour tout sur place ; drones , tourelles automatiques , surveillance via cameras , système d’écoute globale de la population via internet,telephonie mobile etc … ils ont pas beaucoup de personnels dispo sur place alors ils ont tout automatisé.

Quelque chose me dit qu’elles sont toutes programmées selon des critères qui en ont rien a cirer des traités , loies ou règlementations en vigueure. Sans exceptions. Les droits de l’homme , c’est pas pour les Palestiniens ; les « animaux humains » dans la tête des gens qui ont mis en place ces programmes.

+11

AlerterQui est coupable ?

Pas moi repond Eichmann, je ne fais qu obéir

+9

AlerterPhotos destinées à manipuler dans le « bon » sens. Mettez aussi les photos des morts israéliens pour faire bonne mesure ! Quelle différence finale entre cette IA et les décisions de Nagasaki, Hiroshima, Dresde etc ? Aucune : les civils trinquent

+6

Alerterles néolibéraux , les capitalistes , le patriarcat a besoin de l’automatisation de la guerre .A force de dire y’a pas de société , ben on l’a cru .Et puis qui va vouloir se battre pour une société comme celle ci ? Inégalitaire , violente , antidémocratique .Toutes les sociétés n’ont pas eu l’heur de vivre la shoa qui soude les israéliens pour l’instant .Parce que ça aussi ça va s’effacer ,malgré tout ce qui est mis en oeuvre pour le pérenniser . Regardez nous on a eu la révolution et regardez où on en est , démocratie zobi , un coquelet en guise de représentant …Et si il pousse un peu il va peut être nous faire un oeuf . Il manque pas grand chose , financement des partis , et encore y’en aurait meme plus besoin avec des conventions citoyennes tirées au sort , juste besoin de juristes pour mettre en forme les lois .On va faire des économies .A ça faut ajouter deux ou trois petit truc , comme l’armement de la population pour nous prémunir des méchants , ouais on en est pas loin d’une société idéale , c’est ça qui est rageur . Souvenez vous des afghans qui ont foutu tous les démocrates dehors a coups de pieds au fondement eux et leurs IA, meme si eux pensent que la corruption de l’homme justifie le carcan religieux , ils pourraient vivre la même chose sans .Manque pas grand chose …

+4

AlerterLe degré de complexité organisationnel de nos sociétés n’a rien a voir avec celui des cités grecs, il faudrait créer 20 commissions par jour pour légiférer dans des temps raisonnables.

En revanche, dans des sociétés plus simples il est vraisemblable que le citoyen puisse redevenir législateur.

Notre situation relève pour partie des désirs conscients et inconscients des populations et de l’état du monde.

Aujourd’hui nos ressources s’épuisent, la fête du slip s’éclipse et comme nous sommes de furieux aveugles nous n’acceptons ou ne voulons pas comprendre qu’il n’y aura pas de continuum…

L’ambiance enjôleuse et réconfortante des cornucopiens béats inspirés par des « on s’en est toujours sorti », « on arrête pas le progrès », « vers l’infini et au delà », « citius altius fortius » tire encore l’humanité vers des utopies avec des ennemis qui nous jettent dans la guerre.

La thermodynamique défini les possibles, nous devrions nous en inspirer prioritairement.

+2

Alerter« « Pour moi, psychologiquement, c’était inhabituel. Plus de 100 civils – on franchit une ligne rouge ».

à la bonne heure ! il y a même la possibilité de réactions « psychologiques » au carnage

alors que tout un chacun de l’occupant « moral », « courageusement » exposé du haut de son avion / hélico / drone… balance la bombe / le napalm… « dans les règles du droit international » (sic) sur des habitations / écoles /hôpitaux / zones Sud où on a expédié ceux du Nord ou du centre « pour leur sécurité »…

mais puisqu’on vous dit qu’on « obéit aux ordres », hein !

on tire, et après on pleure (éventuellement…)

OBSCENE

+12

AlerterQue pensez d’un « gouvernement » qui procure des armes pour tuer …… et qui parle d’aide humanitaire !!!!!!!!!!!!!!!!!

C’est la position de nos génies délirants hexagonaux que ce soit à Gaza ou Ukraine

L’important c’est de faire du fric, encore du fric et toujours du fric au détriment de toute humanité quel que soit le sujet

OBCENE

Ce que je viens d’écrire va relever de l’article 4 sur la liberté d’expression

+8

AlerterBonjour,

je peux comprendre que la référence historique de mon commentaire vous ait conduit à le supprimer – quoiqu’à un moment il faut avoir le courage de regarder les choses en face.

Je redis néanmoins que la question de la distanciation technique qui désinhibe les auteurs d’un massacre organisé, telle qu’on a pu l’observer par le passé, est encore plus urgente à examiner à la lumière des progrès de l’I.A.

On remplace « c’est pas moi, ce sont les ordres » par « c’est pas moi, c’est l’I.A. » : mécanisme similaire dont les conséquences sont encore plus graves.

Les deux thèmes récurrents de 2024 que sont la guerre et l’I.A. semblent converger, c’est peut-être là le plus inquiétant.

+5

AlerterMerci Actustragicus. Vous avez raison : l’horreur a un pas franchi. Nous avions la guerre avec les bombardements, et maintenant nous avons la guerre avec l’IA et les bombardements.

CEDIVAN, malheireusement, Dresde et Gaza, ce n’est pas la meme chose. Je ne connais pas Dresde, mais un peu Royan, 15 000 habitants durant la 2eme guerre, et un regiment allemand.

Avant le 5 janvier 1945, les moins 16 ages, les vieux, les accompagnants, les femmes , etc … partent en France liberee. Royan est une poche allemande.

ISRAEL a organisee l’arrivee des vieux femmes enfants de Gaza vers son pays Israel ?

Le 5 janvier, bombardement anglais. 500 avions, 500 morts, 1000 blesses, 80 % de Royan rasé. Puis un 3eme bombardement en avril : zero Royan, fin poche allemande.

Entre janvier et avril, les blessés sont escortes par les hopitaux ou Croix Rouge. Evidament libere. Evidemment une organisation militaire « terroristes vs nazi » pour essayer un peu de preserver les civils

Gaza, combien de bombardements ? Combien de bombardements en evitanr les civils (c est l’horreur pour l’histoire de Royan) ? Ou sont escortes les blesses ? La Croix rouge israellienne ?

Y a il une organisation militaire ? Hela, oui : L’IA, c’est la MORT.

+1

AlerterLes commentaires sont fermés.